MIKU BREAK ヒャクセツフトウ

October, 2022

パラスポーツアニメ「バレーボール編」で初音ミク × CONDENSEとして担当したテーマ曲 「ヒャクセツフトウ」のミュージックビデオを公開。 高みを目指して挑戦し続けるすべての人へ熱いエールを届ける曲となっており、何度失敗しても自分の志を変えない『百折不撓』の精神を、バーチャル・シンガー 「初音ミク」とテックダンスフュージョン集団「CONDENSE」がパワフルに表現しています。 MIKU BREAKで初めてとなるミュージックビデオは、最先端の技術を駆使するテクノロジカル・クリエイティブファーム「THINK AND SENSE」と、数々のCM・アーティストの映像作品を手がけるBUDDHA INC.がタッグを組み、MIKU BREAKのテーマである”2次元や3次元などの境界を越え、「境界の無い世界」を表現すること”を追求して制作されました。

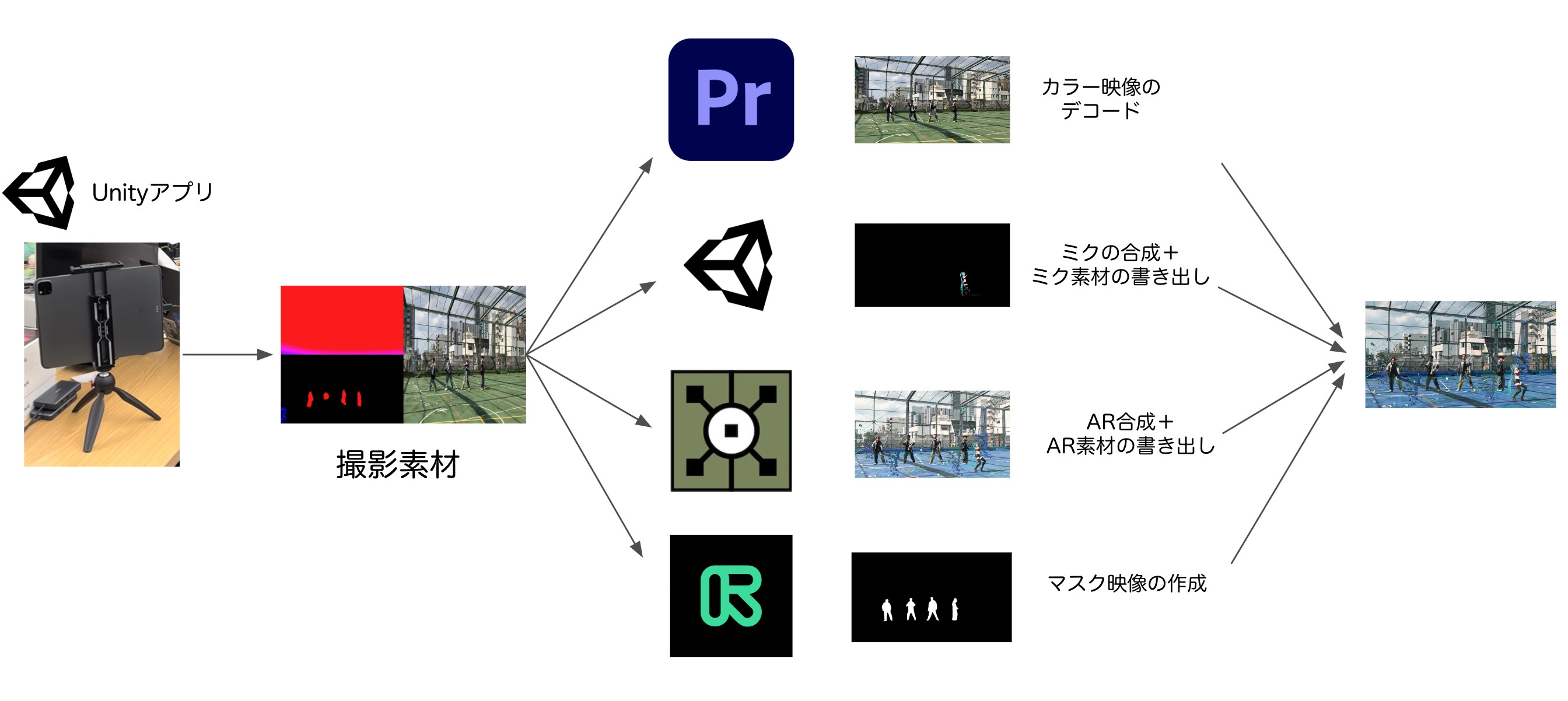

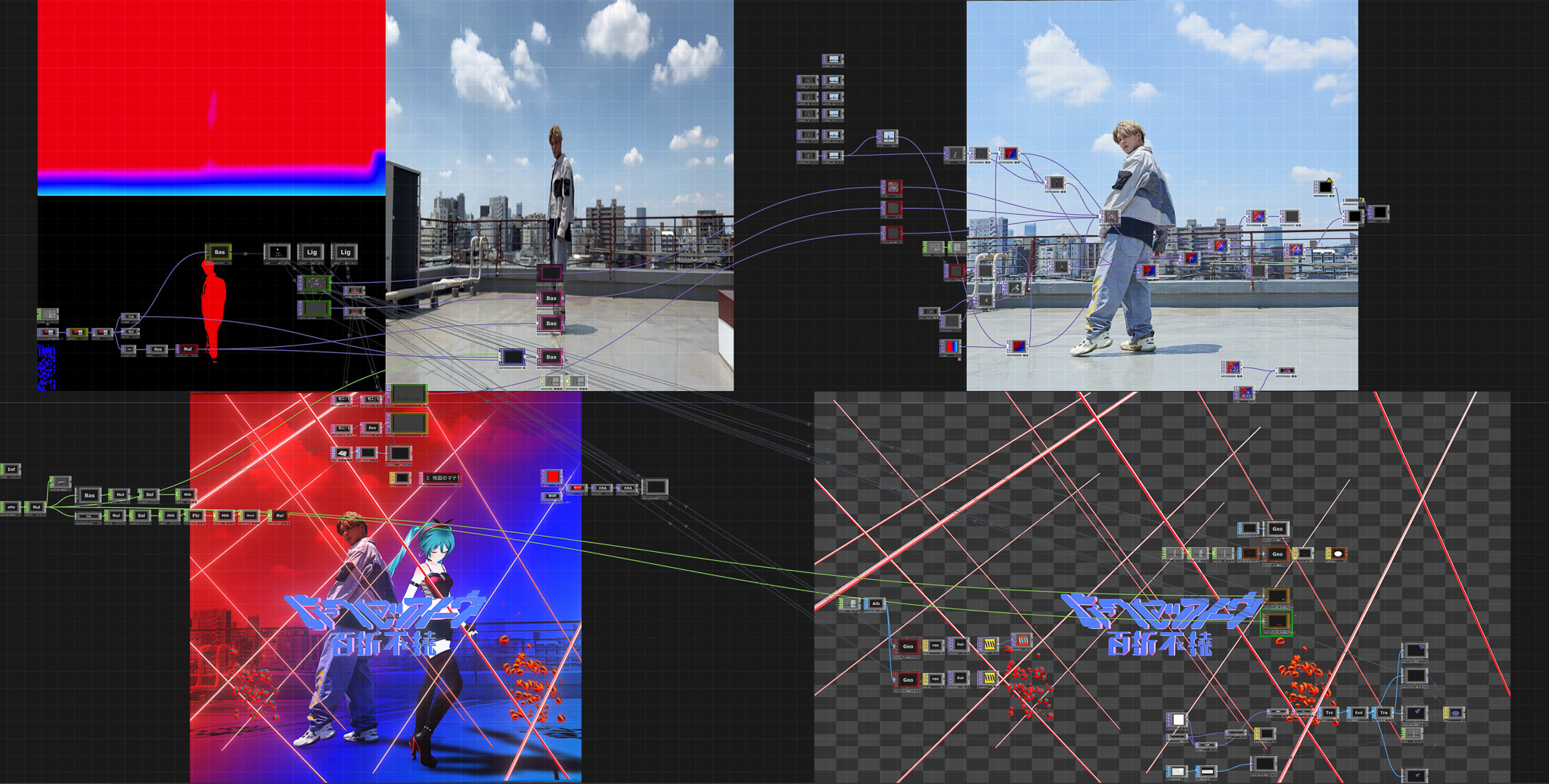

System Design and WorkFlow

CONDENSEのメンバーと初音ミクが現実の世界でパフォーマンスをするという表現の実現のため、本プロジェクトでは、リアルタイムAR合成システムを採用し、 後述の撮影専用アプリの開発から、AR合成のワークフローの構築まで行いました。 専用アプリで撮影を行い、撮影素材を用途に応じてUnity, Premiere Pro, Touchdesigner, RunwayMLで処理を行なっています。それぞれの使用用途は以下の通りです。 Unity: 初音ミクの合成と初音ミク素材の書き出し Premiere: カラー映像部分の切り出し Touchdesigner: ARエフェクトの作成、ARエフェクトの素材書き出し RunwayML: ヒューマンステンシルの作成 これらの素材を用いて、コンポジションを行いました。

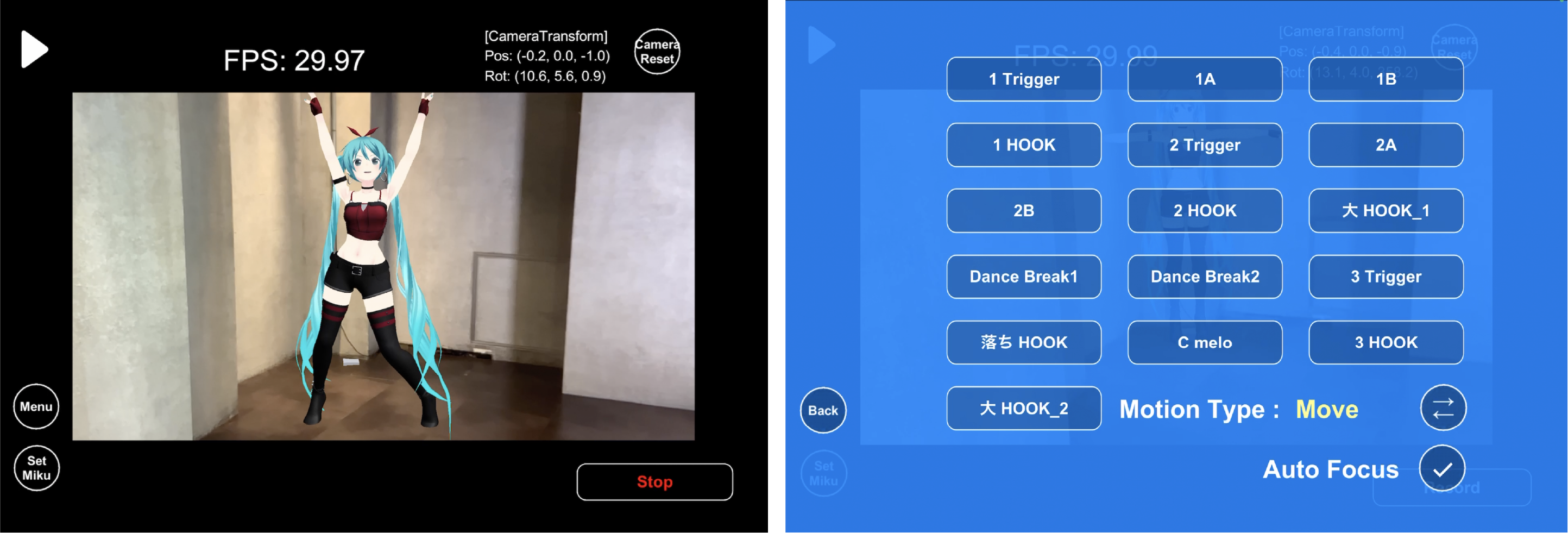

AR Camera App

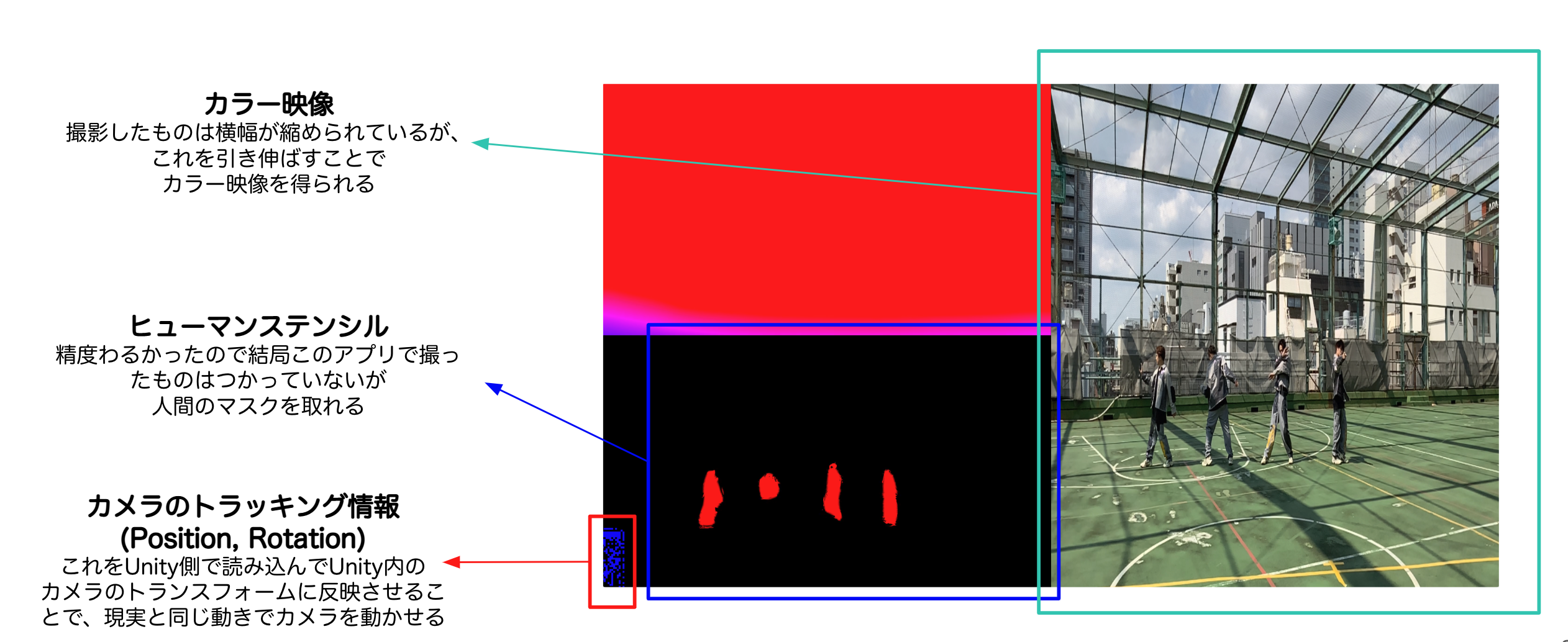

実写の映像とCG映像のAR合成に必要なカメラトラッキング情報やヒューマンステンシル情報を得る手段として、撮影用の専用アプリを開発しました。 iOSアプリケーションとして開発し、iPadを用いて撮影を行ないました。 Keijiro Takahashi氏のオープンソースソフトウェアBibCamを基盤に、今回の撮影の用途に合わせて機能をカスタマイズしています。 今回のMV映像はCONDENSEのメンバーと初音ミクが現実の世界で一緒にパフォーマンスをする趣旨のため、撮影の際には集団でのダンスパフォーマンスのフォーメーションのなかでの、初音ミクの位置を認識した状態で撮影をする必要があります。 通常のカメラでの撮影では初音ミクの位置をリアルタイムで把握できないため、専用アプリ上にARで初音ミクを表示した状態で撮影できる機能を実装しました。 この機能により、カメラマンはパフォーマンスをするCONDENSEと初音ミクの位置をリアルタイムに確認しながら撮影を行うことができます。 また、楽曲の各パートごとで撮影を行っていくため、初音ミクのダンスモーションと楽曲を任意の位置から再生できる機能を実装しました。 楽曲はアプリで再生しBlootoothスピーカーから音を出す手法をとっています。 これにより、パート単位での撮影でも初音ミクのモーション調整等を行うことなくスムーズに撮影を行うことが可能です。 その他の機能としてオートフォーカスのオンオフ、初音ミクのダンスの種類の選択メニュー、FPSの表示など撮影に必要な要素を付け足しています。 アプリで撮影をしたものは下図のように4分割された状態で保存されます。 こちらはKeijiroTakahashi氏のBibCamをベースとしています。

AR合成

ワークフローの1つである初音ミクのAR合成はUnityで行いました。 AR合成では現実で撮影を行なったカメラ座標と、合成するCGをレンダリングするバーチャルカメラの動きを合わせる必要があります。 今回の仕組みでは撮影した映像データにメタデータとして含まれているカメラトラッキング情報を切り出し、Unity上のカメラのトランスフォームに反映させています。これにより現実のカメラと動きとバーチャルカメラをリンクさせることが可能となります。 現実のカメラの動きとリンクされたUnity上のカメラの位置に合わせて初音ミクの位置を調整し、UnityのRecorderを使用して素材の書き出しを行いました。 このようなワークフローで行うことで、初音ミクのダンスの位置を自由に決めることができます。 ARで自由に配置し最終アウトプットに近い映像を見ながらディレクションしました。

リアルタイムAR合成システム

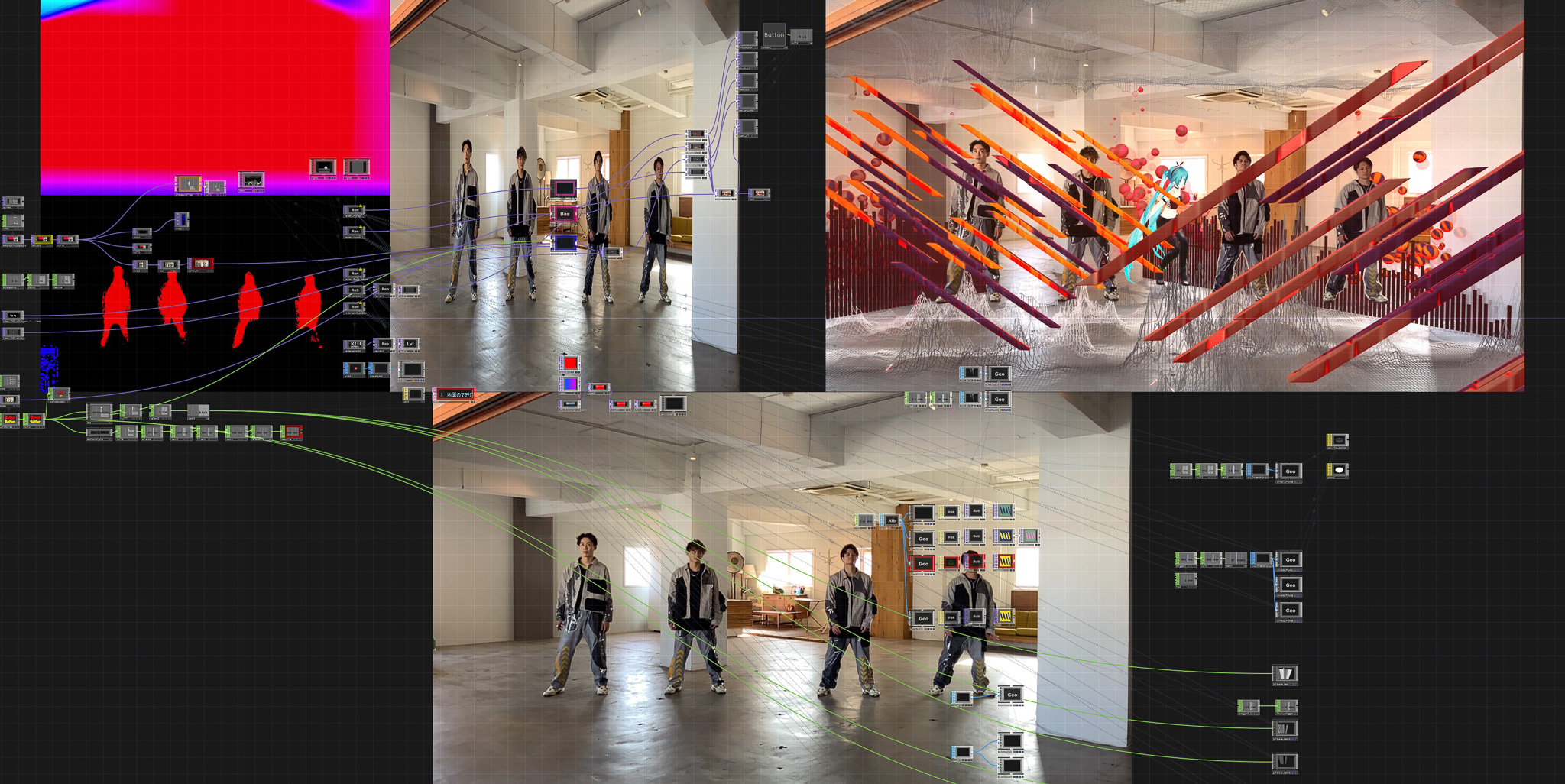

ARエフェクトの合成システムはTouchDesignerを用いて開発を行いました。 専用アプリで撮影された映像データに含まれたカメラトラッキングデータをTouchDesigner内でパースし、ARコンテンツレンダリングシステムのパラメータに割り当てることで、リアルタイムAR合成を実現しています。

ヒューマンステンシル、マルチパスレンダリング等を組み合わせることで、オクルージョンやレイヤーごとのリアルタイムエフェクトの掛け分け等の機能も実装しています。 また、疑似的にAR Objectに対して影落とす機能も実装されています。 複合的な機能からAR Objectのリアリティを高めるシステムを構築しました。

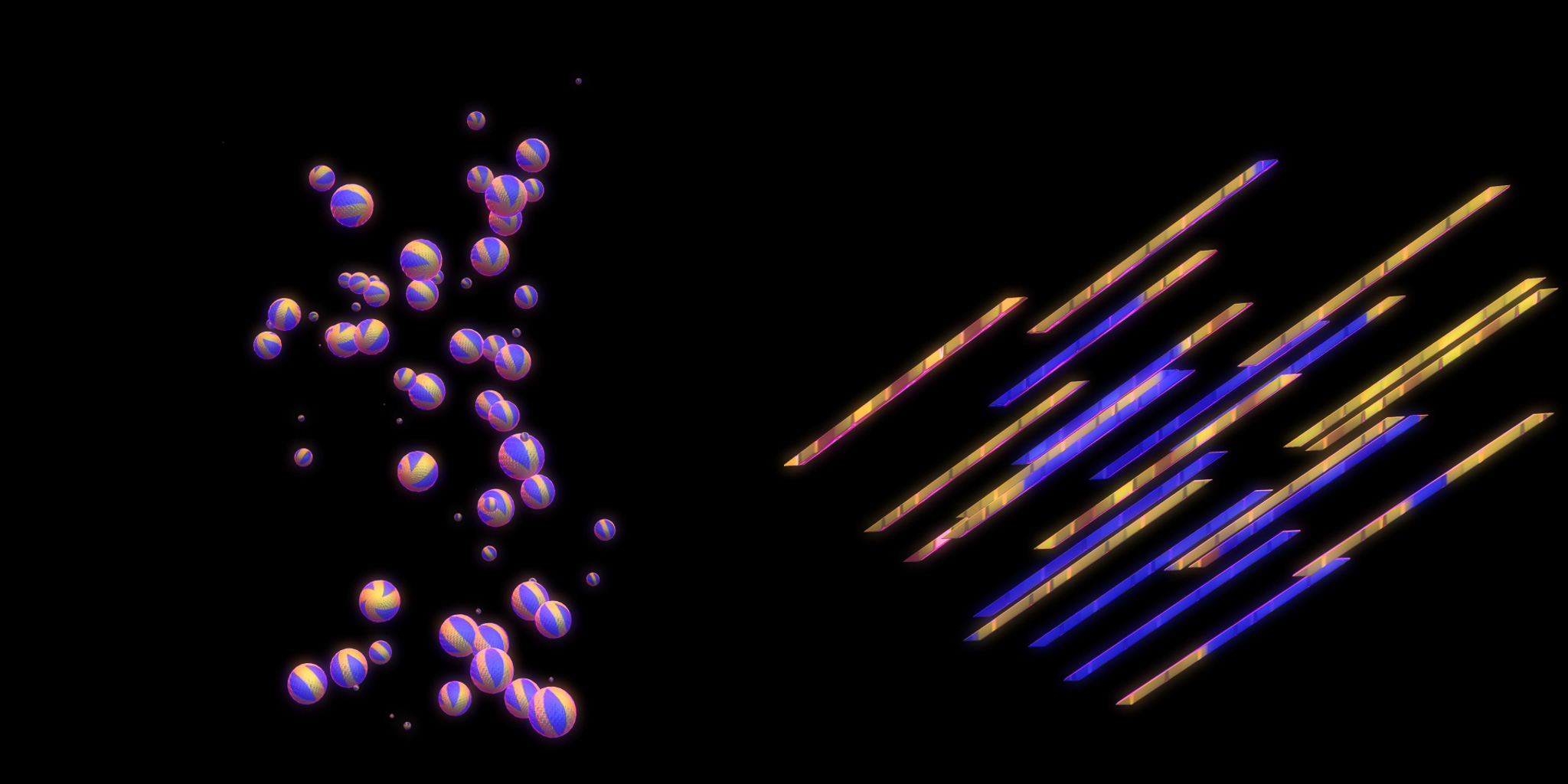

AReffect制作

「境界の無い世界」を表現するために実写映像に対して、リアリティが感じられるARエフェクトの実現が求められました。 AR Objectを空間的に配置し違和感を感じさせず、立体感をもっているように感じられる表現を追及し様々なポイントを考慮し、エフェクトを制作しました。 現実の空間に馴染むようにAR Objectの造形、質感については複数回の施策を行い、よりリアリティが高いと感じられるニュアンスを追及しました。

Jacket Graphics Design

楽曲のジャケット写真のデザインもARエフェクトシステムを用いてヴィジュアル制作を行いました。 写真に対して付加されたカメラの位置データをパースしAR合成を行っています。

Credit ( THINK AND SENSE )

Concept Design,AR Visual Creation:Shuhei Matsuyama AR Shooting App Development, AR character direction : Maple AR Shooting App Development, : Rin Izumi AR Effect Application Development:Ayato Ohkawara AR Effect Application Development:Yuki Hikita AR Effect modeling:Hikaru Kashima character motion authoring :Yutaro Matsumoto character motion authoring:Yuki Soejima

©CFM / T&S