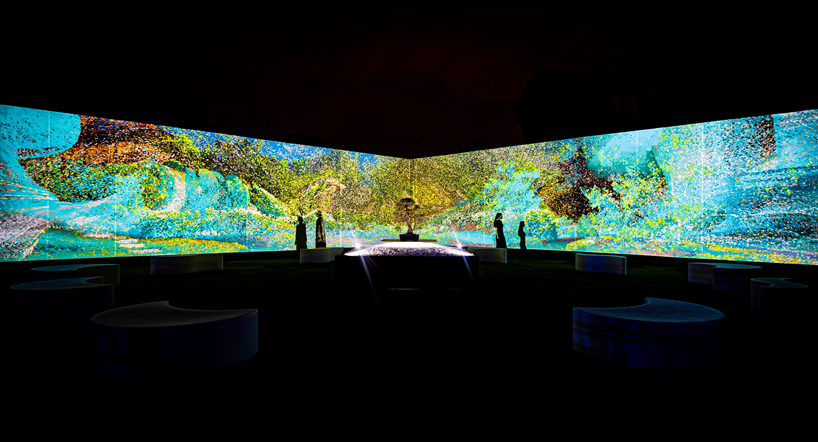

TOKYO LIGHTS 2023 Nov. Immersive WALL Stillness

November, 2023

本作品は、「テクノロジー」×「伝統文化」のコラボレーションから、新しい形の伝統文化芸術体験を提案していく試みの一つです。 デジタルテクノロジーを用いて、禅の思想の一部を言葉ではない体験として表現する一連の取り組みの中の作品の一つとなります。 空間に投影される映像は、高精度レーザースキャン技術により三次元化した両足院のデータを「点群」のランドスケープとして表現したもの。中央に展示された盆栽を両足院にて置かれている様子を撮影した映像から、深層学習を用いたAI画像生成の技術「NeRF」(Neural Radiance Fields)を用いた映像表現を織り交ぜ展開しています。 「テクノロジーの目」を通して捉えた、様々なスケールのデータとしての両足院を副住職との会話を経て得た視点から解釈し、異なる表現として昇華します。 イマーシブ空間は物理的に存在する「盆栽」と物理的にはその場所に存在しない「データとしての両足院」という2つの要素から構成されます。 この2つの要素は日常的につながりの深い物です。 夜の東京でライトアップされる盆栽とデータとしての物理的ではない両足院の情景。 本来日常的なつながりのある2つの要素が異なる表現として設置されるこの場所では、異なる文脈の異質なもののようにも感じられるかもしれません。 この状況を考えることは一つの設問のようにも見えます。 テクノロジーを用いて状況的な問いを発生させるという試みです。 盆栽の持つ自然の美しさ、両足院のデータが作り出す多彩な情景、多重に重なる状況をお自由にお楽しみください。

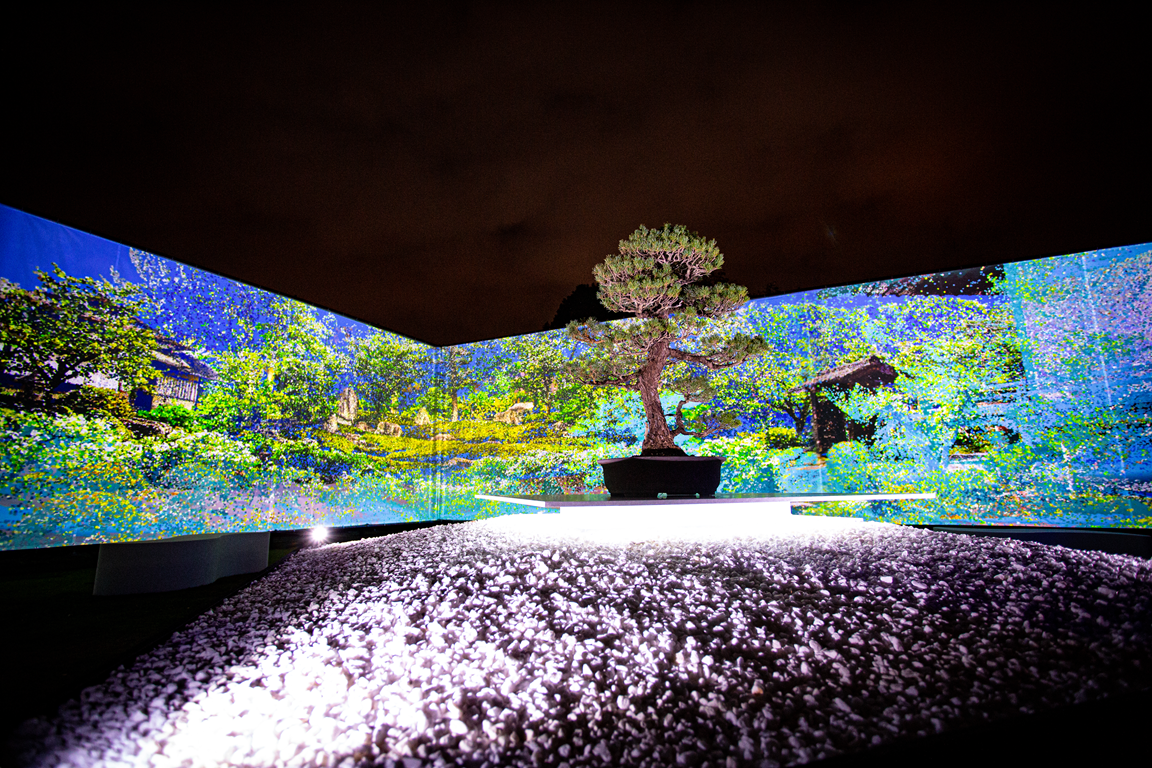

This artwork represents one of our endeavors to propose a new form of traditional cultural art experience stemming from the collaboration between “technology” and ”traditional culture”. This is one of the works in a series of efforts to express a part of Zen philosophy as a non-verbal experience using digital technology. The projected imagery in the space is a “point cloud” landscape visualization created with high-precision laser scanning technology, representing the three-dimensional data of Ryosokuin. This imagery combines footage captured of a scene in which a bonsai tree is placed in the center of Ryosokuin using deep learning-based AI image generation technology called ‘NeRF’ (Neural Radiance Fields) to create a blended visual representation. Ryosokuin as a dataset of various scales and magnitudes, obtained through the ‘eye of technology,’ is interpreted from the perspective gained from conversations with Deputy Chief Priest and is sublimated into unique expressions. The immersive space consists of two elements: physically existing “bonsai” and the non-physically present “Ryosokuin as data”. These two elements are deeply connected in our everyday life. In the scene of illuminated bonsai and the physically non-existent Ryosokuin as data in the night of Tokyo, it appears that they manifest as distinct entities in varying contexts when these two interconnected elements are introduced as distinct expressions. Contemplating this situation may seem like a kind of inquiry. It is our attempt to generate situational questions using technology. Please enjoy the natural beauty of bonsai and the diverse scenes created by the data of Ryosokuin, as well as the multiple overlapping situations.

Workflow and Technical details

本作では両足院にて展示された盆栽の撮影を行い、そのデータをもとに、深層学習を用いたAI画像生成の技術「NeRF」(Neural Radiance Fields)と三次元復元を行ったPointCloudデータを用いて表現を構築しています。 NeRFでは、複数の視点から撮影された画像データとカメラの位置情報を学習リソースとしてニューラルネットワークのAIモデルを構築することで、高い精度で3D空間の形状を復元することが可能です。 NeRF映像を生成する際の三次元空間上でのカメラ情報を共有することで、PointCloudデータをNeRF生成映像と同空間上に配置しレンダリングするシステムを構築し制作を行いました。

In this piece, we captured images of bonsai displayed at Ryosokuin. Based on this data, we used the deep learning-based AI image generation technology ‘NeRF’ (Neural Radiance Fields) and three-dimensionally reconstructed PointCloud data to create the expression. NeRF enables high-precision 3D spatial reconstruction by building a neural network AI model that learns from image data captured from multiple viewpoints and the corresponding camera position information. By utilizing the 3D position of the camera used in generating the NeRF images, we created a rendering system to render the PointCloud data in the same NeRF image space to produce the final output.

Credit (THINK AND SENSE)

Concept,Visual Creation : Shuhei Matsuyama Shooting, NeRF Engineering : Narumi Takakura Shooting, Production management : Naoya Takebe Production management : Takumi Ito Projection System Engineering : Ayato Okawara Space Design : Lai Siuchung Space Design : Yoshida Kiato NeRF System Engineering: Shun Sasaguri Point Cloud System Engineering:Takamitsu Masumi